※これはセミナー聴講時の個人的なノートをそのまま公開したものです。誤字誤植や勘違いがある可能性があるのでご了承ください。

DLLAB 製造・流通分科会アップデート - connpass

15:00-16:30 DLLAB 製造分科会 技術検証取り組み紹介

- 2つの課題設定に対する、各社の検証結果を共有する

- ユーザー企業については、課題をオープンにして、社内データを提供していただいたことに感謝

- パートナー企業については、高難易度で短納期でチャレンジしていたいたことに感謝

- より多くの企業に参加していただいて、課題と技術のマッチングを今後もしていきたい

ミスミグループ本社様「不定形フォーマットカタログからの製品情報抽出」

「課題設定」株式会社ミスミグループ本社 宋美沙氏

- リテラシーや経験がない。でも何かしなきゃ。期待値主導のPoC

- 知識・経験不足で、エヴァンジェリストとして機能しない。とにかく足りないところを埋めるということで、DLLABの分科会に参加

- 問題 誌面が複雑。専門用語や詰め込みすぎで認識ミスが多そう

- 分科会でのお題: データ構造化は無視して、テキスト抽出に絞った

「検証結果」株式会社3AS 山元博生氏

- 取り組みのスコープとアプローチ: 過去のペーパーカタログから文字領域と表領域を識別し、ページ認識情報のアノテーションを作成

- 表領域からの文字抽出まではできていないが、文字領域からの抽出はできた

- 使ったモデルは SENets: [1709.01507] Squeeze-and-Excitation Networks

- 抽出委した文字領域から、文字の輪郭を基に1文字ずつ文字を抽出して文字認識する

- そこそこ良い結果が出ている

「総評」ミスミグループ 宋美沙氏

- 適切な課題設定の粒度は何か?

- 場数を踏むだけではなく知識が必要

- アプローチがユースケースにフィットしているか?

- アルゴリズムの議論をするには、ユーザー企業側にも理解できる人が必要

- 結果として別のゴールが見付かってもそれでよしでいいと思う

トヨタ紡織様「CAD図面からの物体自動学習」

「課題設定」トヨタ紡織株式会社 田尻泰彦氏

- AIを使って工場内の部品(フレーム、フロントバックのカバーなどなど)の動きを捉えていく

- 全部品・全製品へのアノテーションが必要だが、非現実(1シートで300点もある)

- 3Dスナップショット(今回はフロントクッション)から形状を学習してみる

「検証結果」株式会社3AS 山元博生氏

- アノテーションをどうするかに着目

- 3Dデータから2Dに落とすか: 多方向から撮影

- カラー画像、グレースケール画像、ネガポジ画像で検証

- カラーからグレースケールへの変換でエッジ抽出してから物体検出: 検出できなかった

- グレースケール+ネガポジ変換で物体検出: 白っぽいと検出できた

- 色が付いていないと検出率は高くない

- 光源は精度に影響しやすいので、今後は光源を変えてやってみる

「検証結果」SCSK株式会社 帯津勉氏

- CADデータをいかにアノテーションなしで学習させるかに着目

- さまざまな角度のCG画像を作成

- (1)作業CG画像からシート全体を検出し、(2)次に精度の良いFC(実写)検出を行う、という2段階

- 独自のAI検出ツール「」を使った

- (1)ではバックに他の画像を重ねる: 機械的に行った

- 結果: 再現率は53.1%、適合率は94.4%

- 考察:学習件数250件では、十分な精度に至ってない

- 追加検証:特徴不足の補完(実写に近いデータを混ぜたが精度は逆に下がった)、画像数の補完(3750枚に増やすと特徴を細かく判定するようになった)

- 十分な検出精度は出なかった

「検証結果」BLUE TAG株式会社 小川兼司氏

- 色やテクスチャは極力使わないアプローチを考えた

- まず、セグメンテーションは自動で行う。輪郭がシートでないものは除外する

- 3Dデータを使ってさまざまな角度の画像を作成

- 次に、深度推定の学習済みモデルを用意

- 深度が正しく反映されていない: 複雑な図形だとAIも混乱するのかも

- エッジ検出: 2値化(マスク)で行う

- Hu Momentは台形変換に対して不変ではないので、それほど当てにならない

- エッジ検出画像をオートエンコーダーでも検証

- R-CNNの学習済みモデル

- いずれもそれほど良い精度が出せていない

「総評」トヨタ紡織株式会社 田尻泰彦氏

- 3AS: グレースケールよりカラー画像の方がよいのは意外

- SCSK: 先に大きなものと捉えて、次に小さいものは有効

- BLUE TAG: 画像がダメだった

- 最初のトライができて良かった

- やりたいことは汎用的なので、誰か作ってもらえると転移学習できるのではないか

16:45-17:45 AI カメラによるデジタルマーケティング 株式会社TRIAL CTO 松下伸行氏

- 九州のスーパーマーケット「TRIAL」

- 犬猫画像の判定精度はこの10年で大幅に飛躍した

- スマートフォンでも認識できる(Xperia Z4の料理認識エンジン)

- しかし小売りは人間が見ている。ここにAIカメラを入れる

- Retail AI, inc. - Cyber Store Platform

- 棚が分かるAI、最適に切り替えるAI

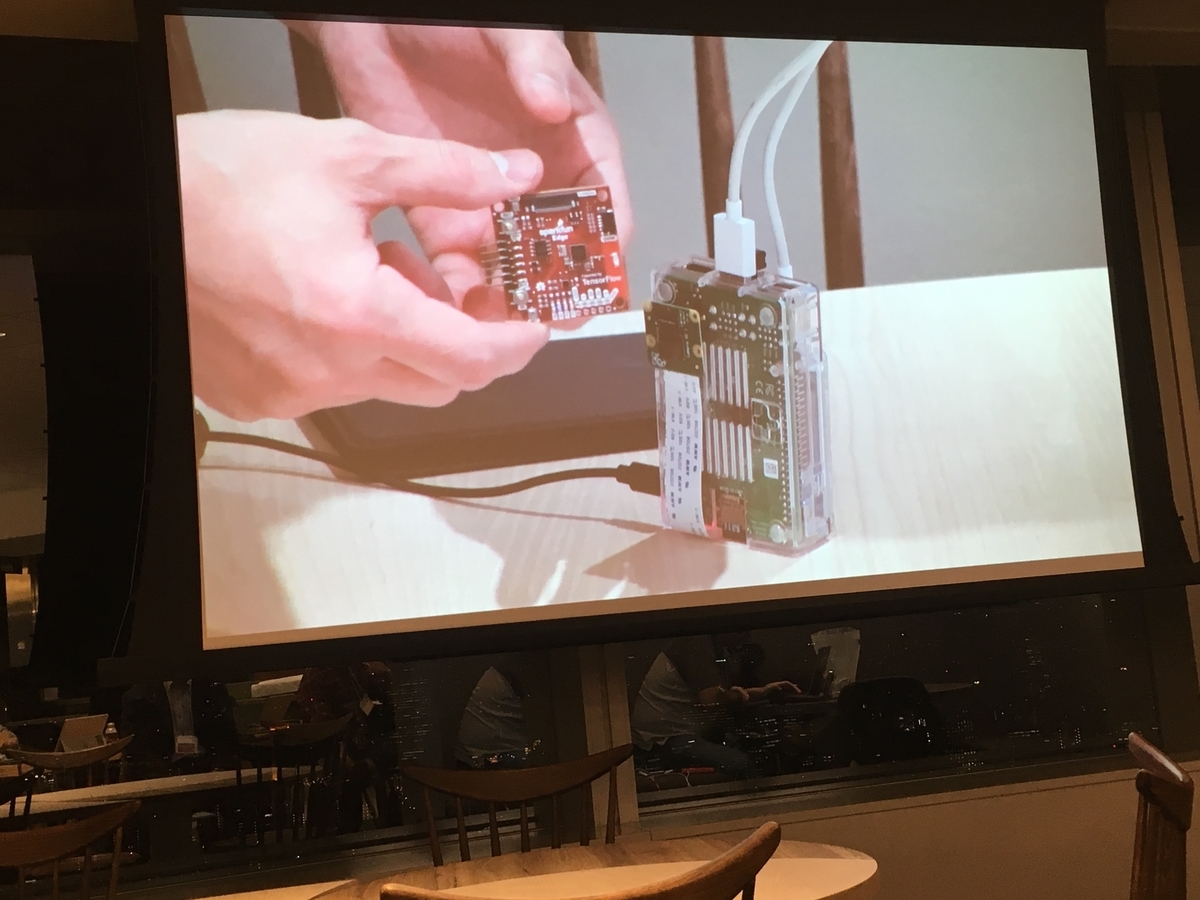

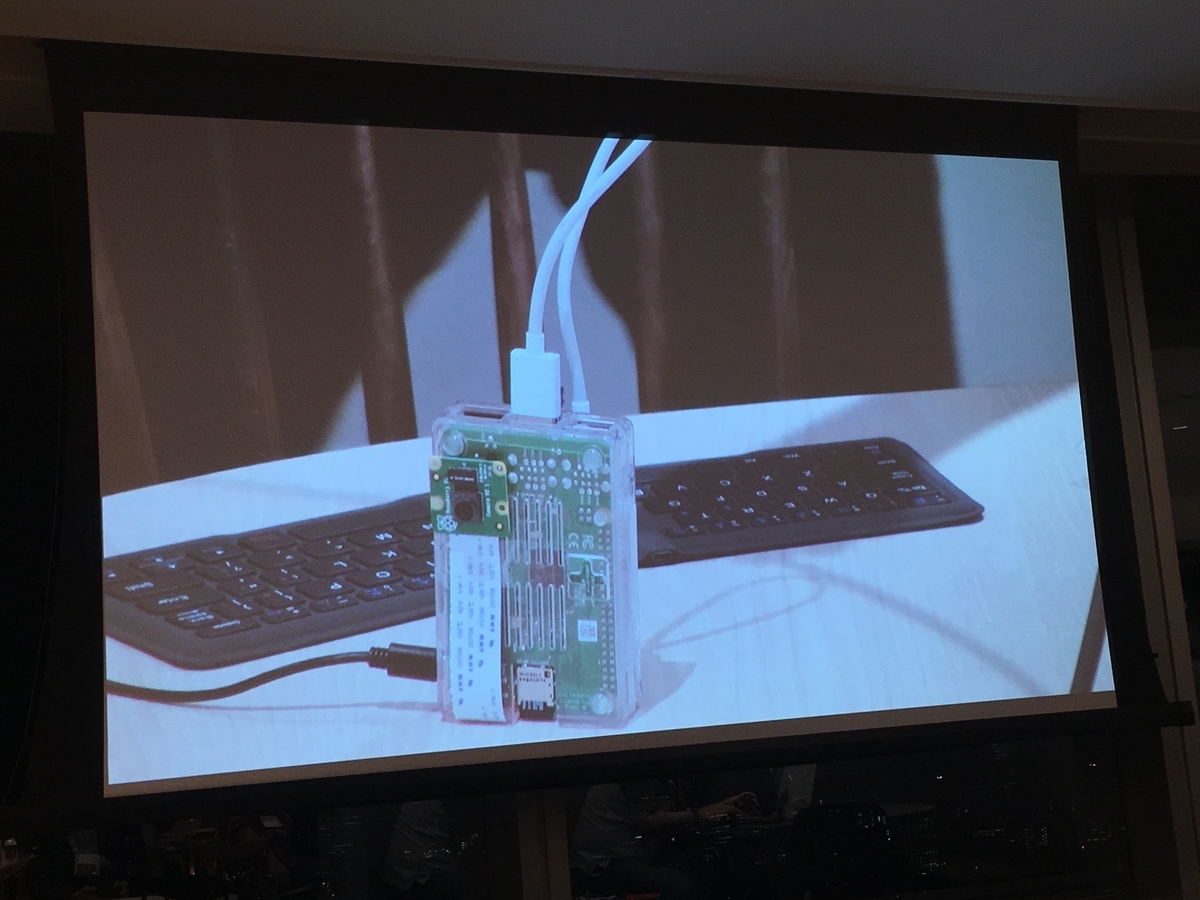

- AIカメラ(AIエンジン+カメラ)「RAICA」を深センで作っている

- まず600台、今は2000台を作った、次は3万台の予定

- 普通のカメラは汎用的だが高い。RAICAはリテールに特化して安くしている

- RAICA-Z1:名刺サイズ=値札につけるため

- 1300万画素(800万画素で人は十分だけどオートフォーカスをするため。商品の図柄を見るためには1000万画素は必要)

- Android/CPU /GPU

- WiFi、バッテリー、USBチャージ、HDMI

- リアル店舗であれば、非計画購買(衝動買い、ついで買い)をできる。棚全部を売り出したいコーラーだけにするなど

- 人認識、商品認識

- 何段か組み合わせることによってできるようになった

- 1年くらいやるとようやく実用可能なモデルが完成する

- どっちの棚がどれくらい売れたかが分かる

- 店舗ごとに陳列方法や棚なの色が違うなど。OpenCVだとブランチが増えてしまう。ディープラーニングなら追加学習してどんどん賢くなる

- 性別や年齢を識別してインタラクティブにサイネージ(広告)が切り替わる

- Retail Iot(カメラ+サイネージ)

- エッジ+クラウド: 最初にクラウド側で学習していき、精度が出るようになってからエッジ側に持っていく

- 汎用的なノウハウは共有する

17:50-18:20 小売業におけるAIの活用とDLLABとの連携 Retail AI 研究会 代表理事 田中雄策氏

- リテールAI研究会: 正会員59社、賛助会員91社、流通会員19社

- トップ | リテールAI研究会

- 流通業界には一筋縄ではいかない課題も山積み。課題解決の共有と緩衝材としての役割を果たしたい

- 情報共有、実験、普及・PR、人材育成

- 人材育成としてR検定を作る予定

- 技術は出そろったが、どう使うか? コストに見合うか? 落とし穴はないのか?

- TRIALの事例:アイランドシティ店(AIカメラの導入など)、大野城店(キャッシュカードでチャージ、夜間無人化など)、新宮店(2019年4月オープン)

- リテールメディア: スマホにクーポン、サイネージ広告などを、店舗に入る前、歩くとき、出るときと適切なタイミングでプッシュする