ウォーキングに興味がある人向けに、スマホを使ったバーチャルイベントの紹介です。

スマホを使ったウォーキングイベント

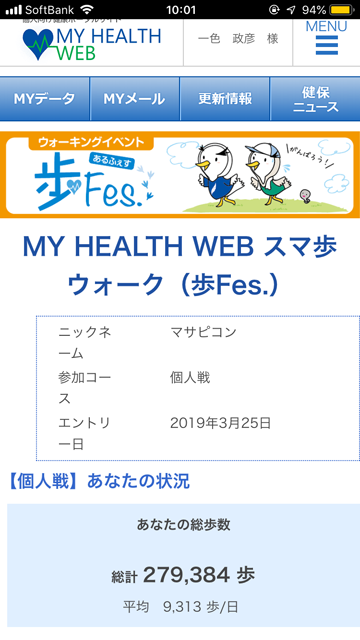

企業が入っている健保では、(被保険者を建康にして医療保険費を削減するためだと思いますが)スマホのアプリを使ったウォーキングイベントというのがよくあると思います。例えばITS(関東ITソフトウェア健康保険組合)では「MY HEALTH WEBスマ歩ウォーク(歩Fes.)」というのがたまに開催されていて、最近だと2019年4月23日(火) ~ 2019年5月22日(水)で開催されました。わたしも参加して、GW期間中サボったので後半の巻き返しが大変だったのですが、何とか平均歩数9000歩以上(歩数達成賞=1000ポイント、つまり1000円相当)を達成しました。

普段の生活の中で自然に実践できるので、ウォーキングイベントはほぼ趣味のように毎回参加しています。ただ、こういったイベントがあるのはたまにであったり、健保ごとであったりするので、参加機会はそれほど多くないです。

からだカルテ:歩数イベント 高知編

そこで、今回のブログ記事で紹介するのは、

というものです。ちなみに以前にも、「ウォーキングの歩数をバーチャル名所で競う「歩数イベント」 - いっしきまさひこBLOG」という紹介記事をポストしたことがあります。からだカルテの歩数イベントも開催は「たまに」なのですが、タニタが開催しており、参加費500円(税込)がかかるものの、誰でも参加できるメリットがあります。

すでに今日(2019/06/03)から始まってしまっていますが、興味があれば上記リンク先をチェックしてみてください。参加する場合はともに頑張りましょう。

今回は高知編で、以下のようなマップの道のりをバーチャルに歩くみたいです。