※これはセミナー聴講時の個人的なノートをそのまま公開したものです。誤字誤植や勘違いがある可能性があるのでご了承ください。

Google Developers ML Summit Tokyo 2019 - カンファレンス

10:45 AM - 11:15 AM 機械学習の概要

- 機械学習とディープラーニングに関する基本的な説明(Playground利用)

11:15 AM - 11:45 AM TensorFlow 2.0: Machine Learning Made Easy

- 機械学習などの現状説明、TensorFlowの現状説明、TensorFlow 2.0の説明

11:45 AM - 12:15 PM Cloud ML API 入門

- 製造業、小売業、ヘルスケア業界、メディア&エンターテイメントなど、幅広い分野で機械学習の活用が増えてきている

- しかし機械学習モデルを構築できる専門家は少ない

- そこで掲げているミッションが “AIの民主化”

- (より汎用的)Machine Learning API/Cloud AutoML/Cloud AI Platform(より専門的)

- Machine Learning API: 視覚(画像分析・動画分析)、言語(機械翻訳・テキスト分析)、会話(音声認識・音声合成)

- 利用方法: Google Cloudクライアントライブラリ(各言語ごとに最適化して作られている)、Google Cloud API(クライアントライブラリが未対応の最新機能を使いたいときはこちらを)

- Google Cloud API: gRPC形式とREST形式の2種類がある

- デモ

12:15 PM - 12:35 AM ML Kit 事例紹介

- 機械学習の関心は高いが、モバイルアプリに実装するのはハードルが高い

- ML Kit: そのハードルを下げる

- ZOZOテクノロジーでの事例: ファッションチェックアプリ、ML Kit使用

- オンデバイス推論をサポート(TensorFlow Lite)。アプリには強力な武器となる

12:35 PM - 1:00 PM Actions on Google 事例紹介

- Google HomeのGoogle Assistant×クロネコヤマトの活用事例

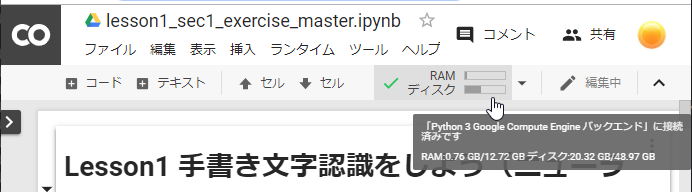

2:00PM - 5:00 PM TensorFlow コードラボ

Advanced version

- Colabs for ML Learning – lmoroney@ : Starts 4

- 代替:Laurence Moroney: Colabs for ML Learning : Starts 4

- Lab 1 — Hello World

- Lab 2 — Basic Computer Vision

- Lab 3 – What are Convolutions and Pooling?

- Lab 4 – Enhance your Computer Vision with Convolutional Neural Networks

- Lab 5 — Using complex images

- Lab 6 – Avoiding overfitting with large data sets

- Dogs vs. Cats | Kaggle

- Keras and modern convnets, on TPUs